切换科目

重点科目

主要科目

次要科目

科数网

首页

刷题

学习

VIP会员

赞助

组卷

集合

教材

VIP

写作

游客,

登录

注册

在线学习

人工智能

旧版本

第一章 线性回归

超参数

最后

更新:

2025-02-17 14:19

查看:

117

次

反馈

能力测评

会员8.2元/月

赞助

超参数

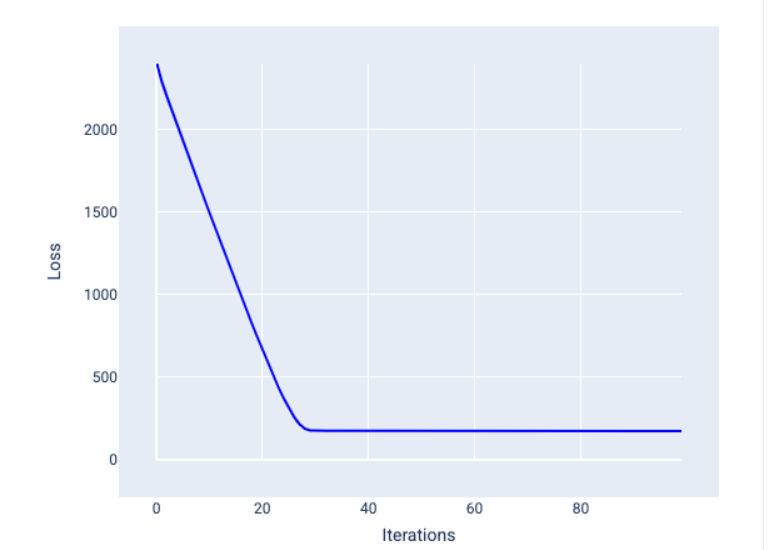

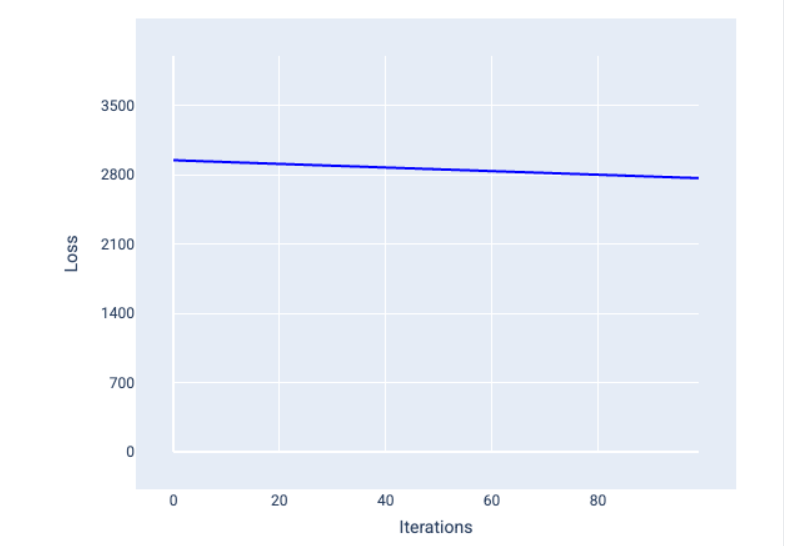

超参数是用于控制训练不同方面的变量。以下是三个常见的超参数: 学习速率 批量大小 纪元 与之相反,参数是模型本身的一部分,例如权重和偏差。换句话说,超参数是您控制的值;参数是模型在训练期间计算的值。 ## 学习速率 学习率是您设置的浮点数,会影响模型收敛的速度。如果学习率过低,模型可能需要很长时间才能收敛。但是,如果学习速率过高,模型将永远不会收敛,而是在最小化损失的权重和偏差之间来回跳动。目标是选择一个学习速率,使其既不太高也不太低,以便模型快速收敛。 学习速率决定了在梯度下降过程的每一步中对权重和偏差进行的更改幅度。模型会将梯度乘以学习速率,以确定下一次迭代的模型参数(权重和偏差值)。在梯度下降的第三步中,向负斜率方向移动的“小量”是指学习速率。 旧模型参数与新模型参数之间的差异与损失函数的斜率成正比。例如,如果斜率较大,模型会迈出较大的步伐。如果小,则只需迈出小步。例如,如果梯度幅度为 2.5,学习率为 0.01,则模型将将参数更改 0.025。 理想的学习率有助于模型在合理的迭代次数内收敛。在图 21 中,损失曲线显示模型在前 20 次迭代中取得了显著改进,然后才开始收敛:  图 21. 损失图,显示使用快速收敛的学习率训练的模型。 相反,学习率过低可能会需要过多的迭代才能收敛。在图 22 中,损失曲线显示模型在每次迭代后仅会略有改进:  图 22. 损失图,显示使用较小学习速率训练的模型。 学习速率过高时,模型永远不会收敛,因为每次迭代都会导致损失出现波

免费注册看余下 70%

非VIP会员每天5篇文章,开通VIP 无限制查看

《高等数学》难点解析

高数教程

泰勒公式

切线与法线

切平面与法平面

驻点·拐点·极值点·零点

间断点

渐进线

瑕积分

欧拉方程

伯努利方程

Abel 收敛定理

偏导数的几何意义

偏导数的几何意义

梯度

数量场与向量场

多元函数极值

拉格朗日算子

通量与散度

环流量与旋度

格林公式

高斯公式

斯托克斯公式

三大公式比较

傅里叶级数

极坐标微元

点法式方程

变上限定积分

X型计算面积

Y型计算面积

微分的意义

渐近线

间断点

y''+py'+qy=f(x)方程

高斯

黎曼

傅里叶变换(复数)

拉普拉斯变换(复数)

高等数学测评

函数与极限

一元函数微分学

一元函数积分学

微分方程

空间向量与代数

多元微分学

多元积分学

无穷级数

《线性代数》难点解析

线代教程

近世代数对数学的整体思考

线性的意义

矩阵乘法(列视角)

矩阵乘法(行视角)

矩阵左乘

矩阵右乘

逆矩阵求解方程组

阶梯形矩阵的求法

方程组解的判定

四阶行列式的计算

线性变换的意义

线性空间

向量组的等价

线性空间的几何意义

基础解系的求法

施密特正交化

特征值与特征向量的意义

矩阵相似的几何意义

矩阵可对角化的理解

秩的意义(向量版)

秩的意义(方程版)

二次型的意义

线性代数测评

行列式

矩阵

向量空间

《概率论与数理统计》难点解析

概率教程

置信区间与上a分位数

概率中的“取”与“放”

贝叶斯公式

全概率公式

泊松分布

指数分布

伽玛分布

二维密度图的意义

卷积的意义

相关系数的意义

k阶矩是与矩母函数

卡方分布的作用

单正态区间估计理解

假设检验理解

切比雪夫不等式

中心极限定理

概率统计测评

事件与概率

一维随机变量与事件

多维随机变量与事件

随机变量的数字特征

大数定律与中心极限定理

统计量与抽样分布

参数估计

假设检验

上一篇:

梯度下降

下一篇:

没有了

本文对您是否有用?

有用

(

0

)

无用

(

0

)

更多

学习首页

数学试卷

同步训练

投稿

会议预约系统

数学公式

关于

Mathhub

赞助我们

科数网是专业专业的数学网站 版权所有

本站部分教程采用AI制作,请读者自行判别内容是否一定准确

如果页面无法显示请联系 18155261033 或 983506039@qq.com