切换科目

重点科目

主要科目

次要科目

科数网

首页

刷题

学习

VIP会员

赞助

组卷

集合

教材

VIP

写作

游客,

登录

注册

在线学习

高中数学

第十二章:概率与统计(高中)

一元线性回归直线方程与最小二乘法★★★★★

最后

更新:

2026-01-09 18:43

查看:

233

次

反馈

能力测评

会员8.2元/月

赞助

一元线性回归直线方程与最小二乘法★★★★★

最小二乘法;一元线性回归模型;误差;误差

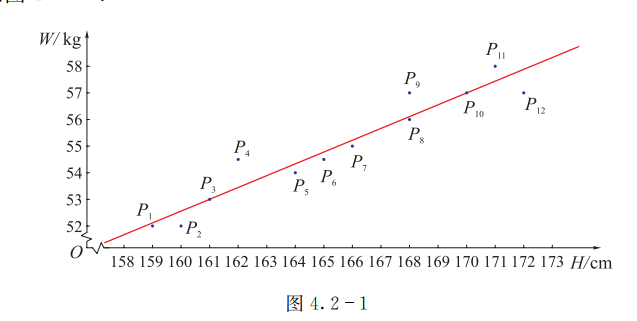

## 一元线性回归直线方程 生活经验告诉我们,儿子的身高与父亲的身高不仅线性相关,而且还是正相关,即父高较高时,儿子的身高通常也较高.为了进一步研究两者之间的关系,有人调查了某所高校14名男大学生的身高及其父亲的身高,得到的数据如表8.2.1所示. {width=650px} 利用身高作为$x$轴,体重作为$y$轴,然后画出散点图,如下图  将一把直尺的一边在上图的散点之间移动,**使它尽量经过或靠近尽可能多的散点**,然后在这一位置上作一条直线,那么这条直线就大致反映了散点图的分布趋势,参考上图. 找出与散点图中各点散布趋势相似的直线,使各点经过或充分靠近该直线,这样所得到的直线就可以比较科学地反映实际问题中两个变量之间的相关关系。这条直线叫作**回归直线**, 这条直线的方程叫作**回归直线方程**。有了回归直线方程,就可以由一些变量的值去估计或预测另一些变量的值. 由散点图求出回归直线并进行统计推断的过程叫作**回归分析**。 在回归分析中,被预测或被解释的变量称为**因变量**,用 $y$ 表示.用来预测或解释因变量的变量称为**自变量**,用 $x$ 表示。 对于具有相关关系的两个变量,可以用一个线性方程来表示它们之间的关系。 ## 一元线性回归方程 如果具有相关关系的两个变量 $x, y$ 可用方程 $$ \boxed{ y=a+b x ...(1) 回归直线方程 } $$ 来近似刻画,则称(1)式为 $y$ 关于 $x$ 的**一元线性回归方程**,其中 $a, b$ 称为**回归系数**. 由于我们是利用样本数据(一组观测值)去估计总体的回归直线方程,因而根据样本数据 $\left(x_i, y_i\right)$ 估计出来的回归系数一般不同于(1)式中的 $a,b$ ,于是我们在 $a, b$ 的上方加记号"^",以示区别.同样,当自变量 $x$ 取值 $x_i$时,其相应的因变量(实际观测值)$y_i$ 与根据(1)式估计出的对应于 $x_i$的纵坐标 $y_i$ 之间一般是有区别的,因而也在 $y_i$ 的上方加记号"^"。 此时得到估计的回归直线方程形式为 $$ \boxed{ \hat{y}=\hat{a}+\hat{b} x ...(2) 估计的回归直线方程 } $$ 它是根据样本数据求出的回归方程的估计. 由于受测量等各种因素的影响,估计值与实际观测值往往不相同.当自变量 $x$取值 $x_i$ 时,我们将根据回归直线方程估计出的 $\hat{y}_i$ 与实际观测值 $y_i$的误差,即 $y_i-\hat{y}_i=y_i-\left(\hat{a}+\hat{b} x_i\right)$ ,称为**随机误差**或**残差**,记作 $e_i$ ,如图 4.2-2.  我们把 $y_i=\hat{a}+\hat{b} x_i+e_i(i=1,2, \cdots, n)$ 这一描述因变量 $y$ 如何依赖于自变量 $x$和随机误差 $e_i$ 的方程称为**一元线性回归模型**. 由于用于描述 $n$ 对观测值 $\left(x_i, y_i\right)$ 的直线有多条,究竟用哪条,需要一个明确的原则.我们自然会想到,**应找一条与实际观测值之间的随机误差最小的直线**。 ## 最小二乘法 德国著名数学家高斯提出用随机误差的平方和即 $Q=\sum_{i=1}^n\left(y_i-\hat{a}-\hat{b} x_i\right)^2$ 作为总随机误差来刻画各估计值与实际值之间的误差,他被称**作拟合误差**。.若总随机误差最小,则这条直线就是所要求的回归直线。由于平方又叫二乘方,所以这种使"随机误差平方和最小"的方法叫作**最小二乘法**. 可求得其值为 $$ \boxed{ \left\{\begin{array}{l}\hat{b}=\dfrac{\sum_{i=1}^n\left(x_i-\bar{x}\right)\left(y_i-\bar{y}\right)}{\sum_{i=1}^n\left(x_i-\bar{x}\right)^2}, \\ \hat{a}=\bar{y}-\hat{b} \bar{x} .\end{array}\right. } $$ 若令 $\bar{x}=\frac{1}{n} \sum_{i=1}^n x_i, \bar{y}=\frac{1}{n} \sum_{i=1}^n y_i$ ,则上式又可以写成 $$

其他版本

【概率论与数理统计】一元线性回归

免费注册看余下 70%

非VIP会员每天5篇文章,开通VIP 无限制查看

《高等数学》难点解析

高数教程

泰勒公式

切线与法线

切平面与法平面

驻点·拐点·极值点·零点

间断点

渐进线

瑕积分

欧拉方程

伯努利方程

Abel 收敛定理

偏导数的几何意义

偏导数的几何意义

梯度

数量场与向量场

多元函数极值

拉格朗日算子

通量与散度

环流量与旋度

格林公式

高斯公式

斯托克斯公式

三大公式比较

傅里叶级数

极坐标微元

点法式方程

变上限定积分

X型计算面积

Y型计算面积

微分的意义

渐近线

间断点

y''+py'+qy=f(x)方程

高斯

黎曼

傅里叶变换(复数)

拉普拉斯变换(复数)

高等数学测评

函数与极限

一元函数微分学

一元函数积分学

微分方程

空间向量与代数

多元微分学

多元积分学

无穷级数

《线性代数》难点解析

线代教程

近世代数对数学的整体思考

线性的意义

矩阵乘法(列视角)

矩阵乘法(行视角)

矩阵左乘

矩阵右乘

逆矩阵求解方程组

阶梯形矩阵的求法

方程组解的判定

四阶行列式的计算

线性变换的意义

线性空间

向量组的等价

线性空间的几何意义

基础解系的求法

施密特正交化

特征值与特征向量的意义

矩阵相似的几何意义

矩阵可对角化的理解

秩的意义(向量版)

秩的意义(方程版)

二次型的意义

线性代数测评

行列式

矩阵

向量空间

《概率论与数理统计》难点解析

概率教程

置信区间与上a分位数

概率中的“取”与“放”

贝叶斯公式

全概率公式

泊松分布

指数分布

伽玛分布

二维密度图的意义

卷积的意义

相关系数的意义

k阶矩是与矩母函数

卡方分布的作用

单正态区间估计理解

假设检验理解

切比雪夫不等式

中心极限定理

概率统计测评

事件与概率

一维随机变量与事件

多维随机变量与事件

随机变量的数字特征

大数定律与中心极限定理

统计量与抽样分布

参数估计

假设检验

上一篇:

多组成对数据的相关性

下一篇:

一元线性回归模型的应用

本文对您是否有用?

有用

(

0

)

无用

(

0

)

更多

学习首页

数学试卷

同步训练

投稿

会议预约系统

数学公式

关于

Mathhub

赞助我们

科数网是专业专业的数学网站 版权所有

本站部分教程采用AI制作,请读者自行判别内容是否一定准确

如果页面无法显示请联系 18155261033 或 983506039@qq.com